只聽過AI你就落伍了,一篇文章讓你秒懂人工智慧的承先啟後

人工智慧已經不再是憧憬而是趨勢的今天,其實已經充滿了不少人工智慧在做生活上囉。

大家還記得之前打敗世界棋王的 Google AlphaGo嗎,以及現在非常火紅的精準醫療和翻譯機器人嗎?

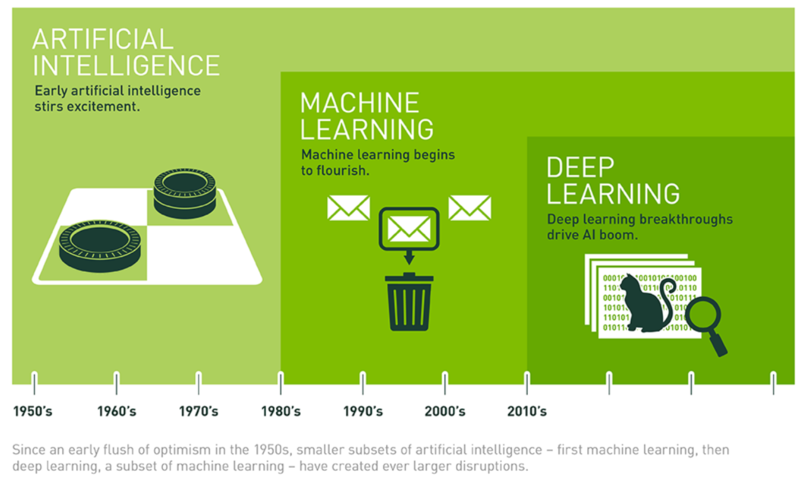

但人工智慧是什麼呢?跟我們先前提到的機器學習有什麼不同。

首先我們必須從「智慧」這個名詞來做一點講究?

強人工智慧就像電影裡面描繪的場景,

機器學習主要的用途同上一篇介紹到的,利用大數據來訓練"機器"

1.獲取數據:機器學習必須先收集大量的數據來對機器進行訓練。

2.分析數據:找出數據的關聯性,也就是變數,例如降雨和濕度。

3.建立模型:透過數據的關聯性做出模型,有點類似人腦的經驗,

4.預測未來:為來可將新的數據輸入模型後,

5.修正預測:透過不斷增生的新數據來修正模型內的參數

簡單來說,從大量的數據資料裡,

但除了機器學習之外,想必最近大家還聽過一個名詞叫做"

假如機器學習是人工智慧的其中一個分歧,

早期機器學習的領域中有一條分支叫做"類神經網路"。

舉例來說,像雅量裡面提到的,

當然過程中會出現大量的錯誤答案,但這也是一個絕佳的訓練機會,

其中最有名的就是2012年,吳恩達在 Google 所製作的貓圖測試,

當然這些硬用上除了在判斷是不是貓咪之外,

僅管現在把這樣的理論可以輕描淡寫的敘述,

而突破性的發展就是NVIDIA 在 2006 – 2007 年間推出全新運算架構 CUDA,讓使用者可以撰寫 C 語言、再透過 CUDA 底層架構轉譯成 GPU 看得懂的語言。這不僅讓NVIDIA身價水漲船高,

所以別再講人工智慧啦,先搞懂機器學習和深度學習的奧妙之後,

最後,如果你喜歡我們的文章,別忘了到我們的FB粉絲團按讚喔!!